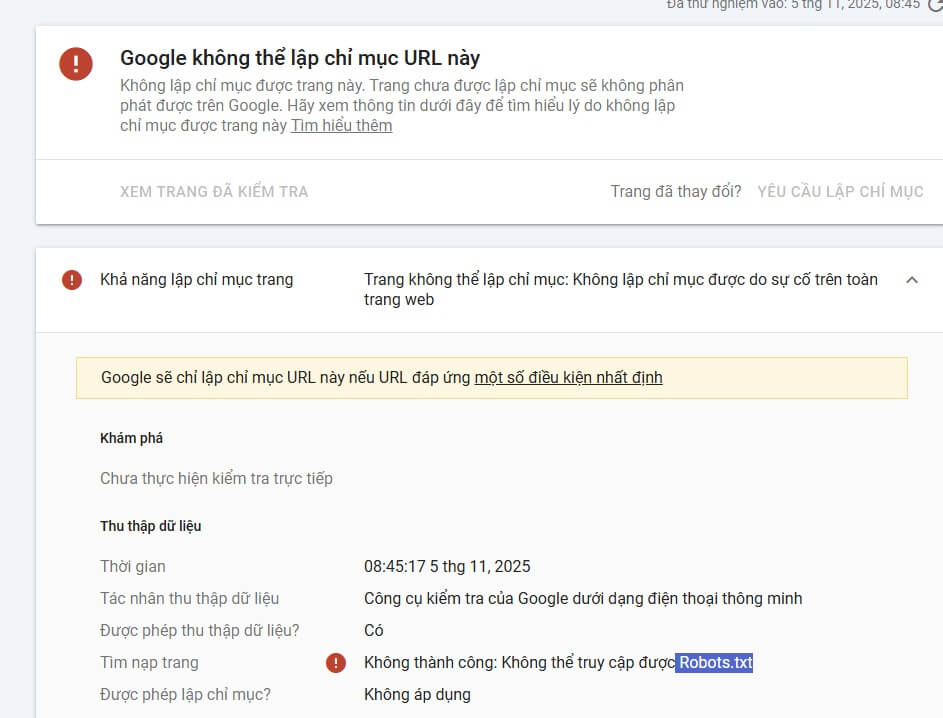

Trong quá trình quản trị website, nhiều người gặp cảnh báo trong Google Search Console với thông báo: “Google không thể lập chỉ mục URL này” hoặc “Không thể truy cập được Robots.txt”. Đây là lỗi thường gặp khiến Google không thể thu thập dữ liệu trang web, dẫn đến việc URL không xuất hiện trong kết quả tìm kiếm. Bài viết này sẽ giúp bạn hiểu rõ nguyên nhân, cách kiểm tra và cách khắc phục triệt để.

Hiểu đúng về lỗi Google không thể lập chỉ mục URL này

Thông báo này xuất hiện khi Googlebot không thể truy cập hoặc phân tích nội dung trang web do một trong các nguyên nhân kỹ thuật. Dù website của bạn hoạt động bình thường, Google vẫn có thể không lập chỉ mục nếu bị chặn bởi:

- File

robots.txt - Cấu hình bảo mật máy chủ

- Tường lửa (firewall) hoặc CDN (như Cloudflare)

- Lỗi DNS hoặc SSL

- Lỗi tạm thời từ hosting

Trong trường hợp cụ thể “Không thể truy cập được robots.txt”, Googlebot đã cố truy cập file https://tenmiencuaban.vn/robots.txt nhưng nhận phản hồi lỗi, nên toàn bộ quá trình crawl bị dừng lại.

File robots.txt là gì?

File robots.txt là tệp văn bản đặt tại thư mục gốc của website (thường truy cập qua https://tenmiencuaban.vn/robots.txt). Tệp này cho phép bạn điều khiển việc Googlebot và các công cụ tìm kiếm khác có được phép thu thập dữ liệu trang hay không.

Ví dụ nội dung robots.txt cơ bản:

User-agent: *

Disallow:

Sitemap: https://tenmiencuaban.vn/sitemap.xml

Nếu cấu hình sai, ví dụ thêm dòng Disallow: /, Google sẽ bị chặn truy cập toàn bộ trang web.

Nguyên nhân phổ biến khiến Google không thể truy cập robots.txt

1. File robots.txt không tồn tại hoặc sai vị trí

Googlebot chỉ tìm file tại thư mục gốc (ví dụ /robots.txt). Nếu bạn đặt sai thư mục hoặc tên khác, bot sẽ báo lỗi “Không thể truy cập được Robots.txt”.

Cách khắc phục:

- Đảm bảo file tồn tại tại:

https://tenmiencuaban.vn/robots.txt - Kiểm tra định dạng là text/plain, không phải

.htmlhay.php

2. Bị chặn bởi firewall hoặc plugin bảo mật

Một số plugin WordPress như Wordfence, iThemes Security hoặc tường lửa của Cloudflare có thể tự động chặn bot.

Cách khắc phục:

- Mở tạm chế độ “Learning mode” hoặc tắt tính năng “Bot Protection”

- Cho phép User-agent:

Googlebottrong danh sách whitelist - Sau đó kiểm tra lại bằng Google Search Console

3. Lỗi máy chủ (Server Error 5xx)

Nếu hosting gặp sự cố (quá tải, ngắt kết nối, lỗi PHP, lỗi SSL), Googlebot sẽ nhận phản hồi lỗi 500 và ngừng crawl toàn bộ trang.

Cách khắc phục:

- Kiểm tra log máy chủ (error log)

- Đảm bảo website hoạt động ổn định 24/7

- Liên hệ nhà cung cấp hosting nếu lỗi kéo dài

4. Cấu hình SSL hoặc DNS chưa ổn định

Googlebot luôn ưu tiên truy cập qua HTTPS. Nếu chứng chỉ SSL chưa hợp lệ hoặc DNS chưa đồng bộ, Google sẽ không tải được file robots.txt.

Cách khắc phục:

- Kiểm tra SSL bằng

https://www.ssllabs.com/ssltest/ - Đảm bảo DNS trỏ đúng IP máy chủ

- Tránh redirect vòng lặp (HTTPS → HTTP → HTTPS)

Cách kiểm tra lỗi robots.txt chính xác

1. Kiểm tra thủ công bằng trình duyệt

Truy cập trực tiếp: https://tenmiencuaban.vn/robots.txt

Nếu hiển thị nội dung dạng text là thành công. Nếu báo lỗi 403, 404 hoặc 500, bạn cần xử lý theo mã lỗi đó.

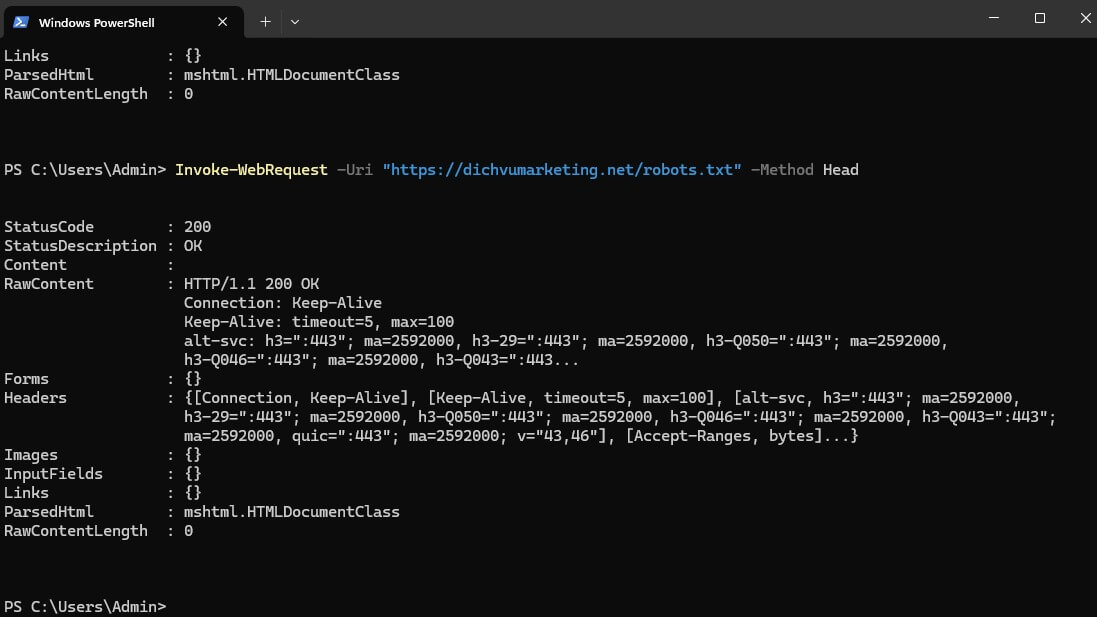

2. Kiểm tra bằng lệnh cURL

Mở Terminal (Mac/Linux) hoặc PowerShell (Windows) và nhập:

curl.exe -I https://tenmiencuaban.vn/robots.txt

Nếu không chạy đúng kết quả bạn có thể dùng dùng lệnh chuẩn PowerShell: Invoke-WebRequest -Uri "https://traicayxanh.vn/robots.txt" -Method Head

Kết quả sẽ hiển thị mã phản hồi HTTP:

| Mã phản hồi | Ý nghĩa | Cách xử lý |

| 200 OK | File truy cập được | Không lỗi |

| 403 Forbidden | Bị chặn bởi firewall hoặc plugin | Cho phép truy cập Googlebot |

| 404 Not Found | Không tồn tại file robots.txt | Tạo lại file |

| 5xx Server Error | Lỗi máy chủ | Kiểm tra hosting |

3. Kiểm tra trong Google Search Console

- Vào Kiểm tra URL → nhập đường dẫn lỗi → nhấn Kiểm tra trực tiếp

- Nếu báo “Không thể truy cập Robots.txt” hãy đảm bảo file có thể tải qua trình duyệt trước khi gửi lại yêu cầu “Yêu cầu lập chỉ mục”

Cách khắc phục lỗi “Google không thể lập chỉ mục URL này”

Bước 1: Tạo hoặc kiểm tra lại file robots.txt

Đảm bảo cấu trúc hợp lệ. Ví dụ chuẩn:

User-agent: *

Disallow:

Sitemap: https://tenmiencuaban.vn/sitemap.xml

Bước 2: Kiểm tra lại quyền truy cập

- Truy cập file bằng trình duyệt → đảm bảo hiển thị bình thường

- Nếu bị chặn, kiểm tra tường lửa, plugin bảo mật hoặc cấu hình máy chủ

Bước 3: Gửi yêu cầu lập chỉ mục lại

Sau khi file hoạt động bình thường:

- Mở Google Search Console

- Dán URL bị lỗi vào ô Kiểm tra URL

- Chọn Yêu cầu lập chỉ mục

- Chờ vài ngày để Google thu thập lại dữ liệu

Bước 4: Kiểm tra toàn bộ website

Dùng công cụ kiểm tra SEO như Ahrefs Site Audit, Screaming Frog, hoặc Semrush để quét toàn trang. Nếu phát hiện lỗi tương tự ở nhiều URL, bạn nên kiểm tra cấu hình máy chủ hoặc plugin cache.

Một số mẹo SEO kỹ thuật để tránh lỗi robots.txt trong tương lai

- Giữ robots.txt luôn truy cập công khai (không đặt quyền riêng tư hoặc noindex)

- Kiểm tra định kỳ bằng Google Search Console

- Không sử dụng redirect từ robots.txt sang trang khác

- Hạn chế chặn toàn bộ thư mục bằng

Disallow: / - Đảm bảo tốc độ phản hồi máy chủ dưới 500ms để Googlebot không timeout

Lỗi “Google không thể lập chỉ mục URL này do không truy cập được robots.txt” không quá nghiêm trọng nếu được xử lý sớm. Nguyên nhân chủ yếu là do file bị chặn, sai vị trí, hoặc lỗi tạm thời từ máy chủ. Hãy đảm bảo rằng robots.txt luôn khả dụng, nội dung đúng chuẩn và không chặn các thư mục quan trọng.

Khi đã khắc phục xong, gửi lại yêu cầu lập chỉ mục trong Google Search Console và theo dõi trong mục “Trạng thái lập chỉ mục”. Sau vài ngày, website của bạn sẽ được Google crawl và hiển thị trở lại trên kết quả tìm kiếm.

Bài viết cùng chủ đề:

-

Locations.kml là gì? Cách tạo file KML Keyhole Markup Language chuẩn SEO

-

Website đã bị cài backdoor là gì ? Cách nhận biết chính xác & xử lý

-

Dịch Vụ cho Thuê Hosting Giá Rẻ website, sever email (49K/tháng)

-

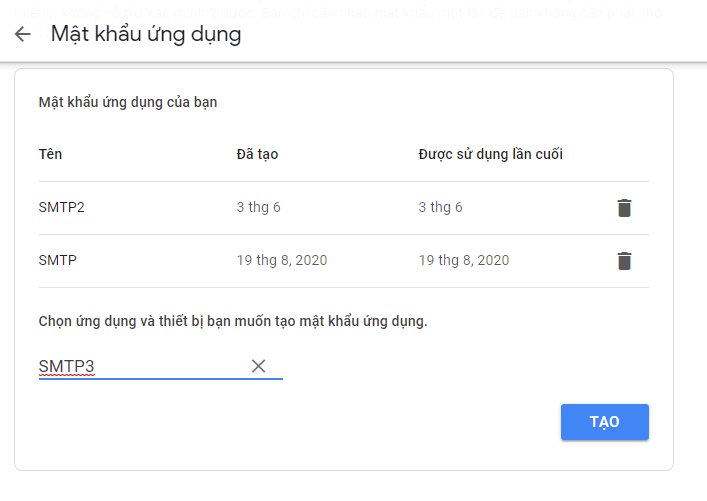

Hướng dẫn Cách tạo mật khẩu ứng dụng Gmail chi tiết

-

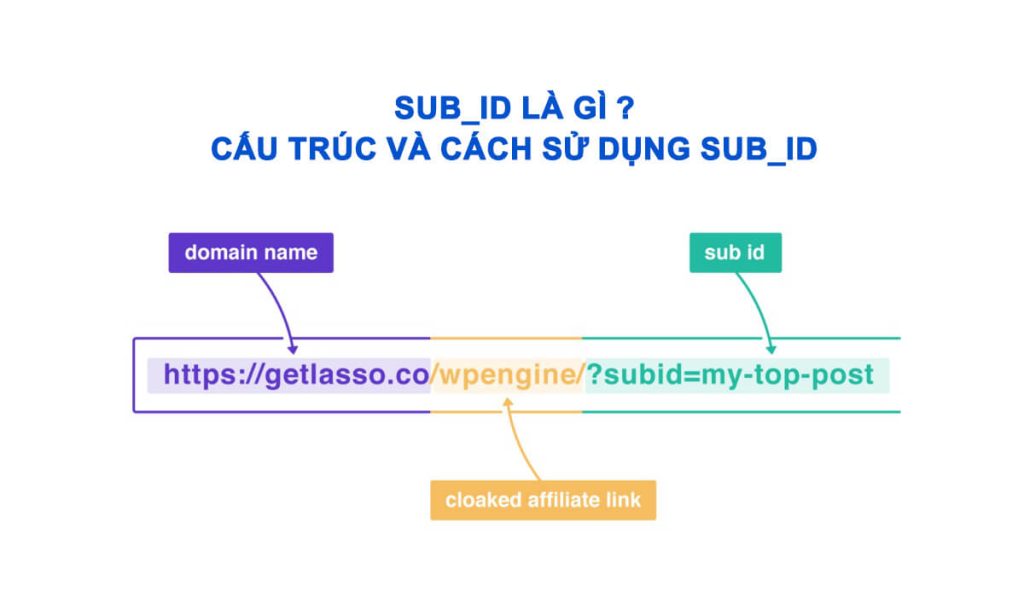

Sub_id là gì ? Cấu trúc và cách sử dụng Sub_id

-

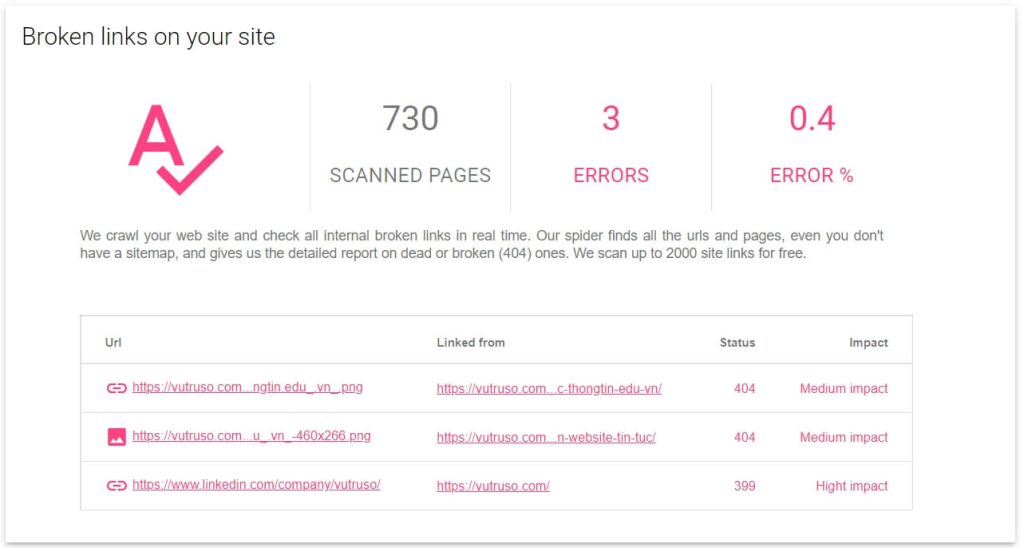

Cách quét và tìm tất cả URL, các hình ảnh lỗi 404 Not website

-

Mua Tên Miền Giá Rẻ Ở Đâu, Báo Giá DNS Mới Nhất Hiện Nay

-

Thuộc Tính rel=”ugc noopener nofollow” Trong SEO & Bảo Mật

Thỏa sức lưu xu hướng bằng tải video TikTok—có/không watermark, hỗ trợ caption.